U našich zákazníků řešíme při přechodu na hyperkonvergovanou infrastrukturu spíše změnu myšlení a přístupu k architektuře datacentra a vlastní výkon celého řešení spadá do kolonky „samozřejmě splněno“. I když před vlastním nasazením přesně víme cílový výkon řešení, občas je žádoucí provést proof of concept, například z požadavku na nasazení hodně nestandardních systémů. Jeden z těchto POC máme čerstvě a úspěšně za sebou a cílem bylo mimo jiné i měření výkonu úložiště. Hodnoty, které ukázal čtyřnodový SSD/NVMe Nutanix cluster, tentokrát překvapily i nás!

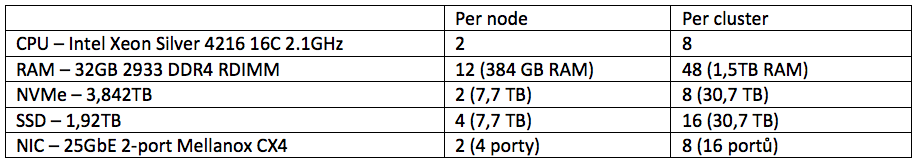

Specifickým požadavkem našeho zákazníka byly poměrně veliké nároky na počet diskových operací za sekundu současně s relativně malým nárokem na kapacitu. Rozhodli jsme se proto o testování na all flash konfiguraci osazenou SSD a NVMe disky a zároveň využívající technologii RDMA (Remote Direct Memory Access).

Testovací konfigurace

- Nutanix cluster NX-3460-G7 (2U šasi obsahující 4 nody/uzly)

- Lenovo NE1032 Rackswitch – 32x 10GbE port

Výkonnostní testy

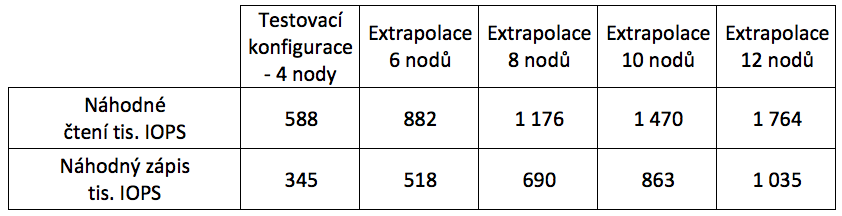

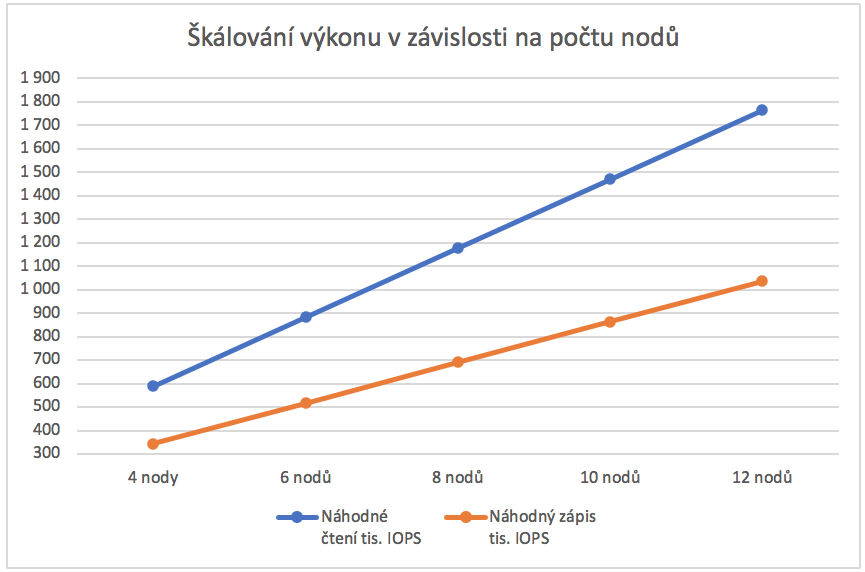

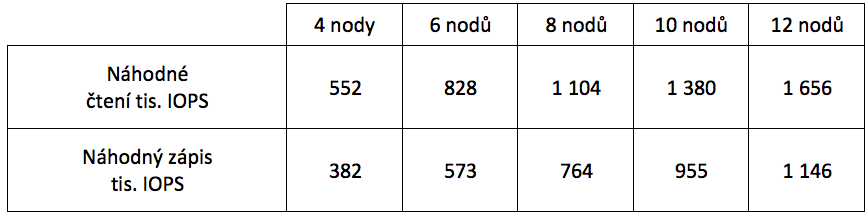

Testy byly prováděny interním nástrojem Nutanix IPerf s ohledem na zjištění dosažitelného výkonu v propustnosti, latencí a diskových operací za sekundu (IOPS). Síťová vrstva byla použita v režimu 10GbE. Kromě IOPS, které jsou uvedeny níže v tabulce, jsme rovněž u čtyřnodového clusteru změřili propustnost. Ta u dané konfigurace dosahovala 4 044 MBps (zhruba 14,5TB/h) pro sekvenční zápis a 9 588 MBps (zhruba 34,5TB/h) sekvenční čtení.

Změřené výsledky v tabulce reprezentují výkon čtyřnodového testovacího clusteru. Další navyšování výkonu/kapacity lze po kroku 1+ node a výkon bude škálován téměř lineárně. Další změny výkonových parametrů jsou možné úpravou konfigurace jednotlivých nodů – CPU, RAM, NVMe, SSD a také změnou použitého šasi, například 1 node per 1U.

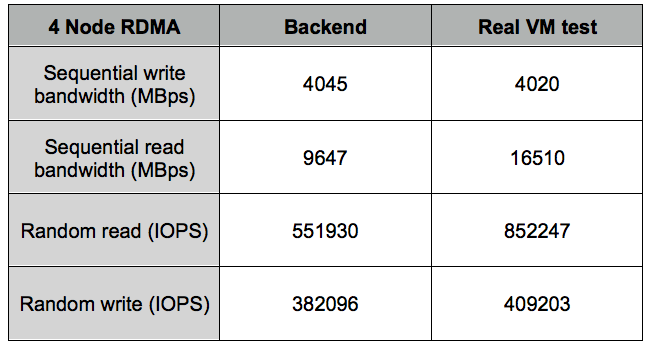

Testování s využitím RDMA

Identický testovací cluster jsme podrobili také měření se zapnutým RDMA (Remote Direct Memory Access), které má zajistit zvýšení výkonnosti právě v oblasti IOPS. V těchto měřeních se projevil použitý 10GbE switch jako úzké hrdlo testovacího systému, přesto došlo v klíčovém parametru IOPS pro náhodný zápis ke zlepšení o více než 10 procent. Pokles hodnoty pro čtení je způsobený switchem, pro který znamená RDMA zvýšenou zátěž.

Při implementaci v produkčním prostředí a využití 25GbE switchů lze očekávat další nárůst, a to zejména při čtecích operacích. Škálování a rozšiřování je pak naprosto shodné jako u varianty bez RDMA. Pro testovanou konfiguraci došlo v klíčovém parametru náhodného zápisu k navýšení o zhruba 11 procent, což je i v souladu s našimi poznatky z praxe, kdy výkonové parametry systémů narostou po implementaci RDMA typicky o 10 až 20 procent. S přihlédnutím k naprosto minimálnímu cenovému navýšení za potřebný HW – síťové karty, lze využití RDMA doporučit.

Testování reálnou zátěží

Pokud vám nesedí hodnoty z tabulky s avizovaným číslem v nadpisu článku, hned pro vás máme vysvětlení.

Je nutné poznamenat, že výsledky viz výše jsou specifické pro backend – HW platformu bez dalšího vlivu optimalizací díky technikám Nutanix Acropolis. Při reálném nasazení pak tyto optimalizace dále zvyšují výkonnost. Reálný scénář nasazení je lépe podchycen testem X-RAY a zde jsou dosažené výkony ještě výrazně lepší než pouze syntetický test backendu. Tyto hodnoty jsou vypovídající o tom, co můžete očekávat při nasazení reálných virtuálních strojů.

Během X-RAY testu probíhá měření výkonnosti virtuálních strojů (VM) i Backendu procesy ve speciálních VM určených k měření (modifikované Ubuntu, RHEL a CentOS). Přesné parametry VM jsou velmi subtilní, 4 vCPU a 4GB RAM. Nejedná se tedy o měření s extrémně nadsazenou kapacitou RAM jak ve VM, tak i CVM. Cash Hit Ratio odpovídá běžné instanci malého Linuxu. Před měřením nebyly prováděny žádné optimalizace AHV, CVM ani testovacích VM.

K testovacímu scénáři a výsledkům je nutno zmínit fakt, že námi použitý switch Lenovo NE1032 má propustnost 10GbE a pro účely RDMA je nutné zapnout CEE (Converged Enhanced Ethernet), LLDP, PFC apod., což má za následek zpomalení switche zhruba o 10-12%. V infrastrukturním testu bez RDMA tak byl switch v některých měřeních rychlejší. Tyto dopady lze zcela eliminovat použitím 25GbE switche, který bude perfektně ladit s Mellanox NIC v Nutanix clusteru.

V následující tabulce je porovnání výsledků Backend raw testů a výsledků z Nutanix X-RAY. V reálném prostředí se budou dosažené hodnoty blížit spíše reálnému VM testu z Nutanix X-RAY.

Kolokační test

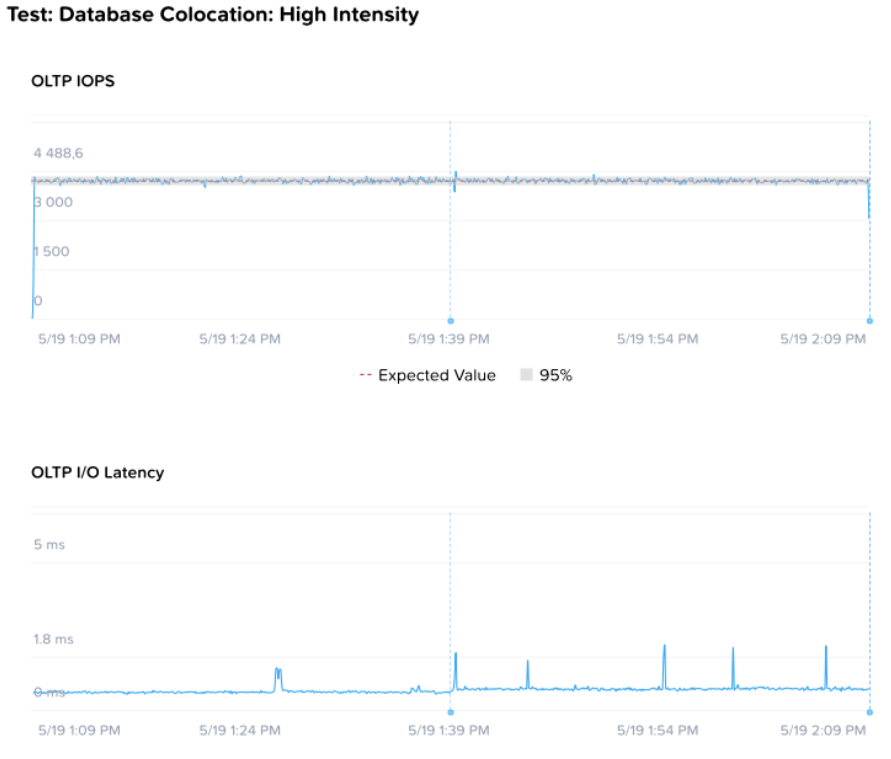

Kromě výkonových testů jsme provedli také kolokační test - měření vlivu zátěže sekundárních systémů na výkon a latence transakční databáze. Z pohledu úložiště jde o hledání a detekci jevu Slow Buffer Drain, kdy běh jednoho systému negativně ovlivní výkonnost celé infrastruktury. Z celého testu je zásadní následující graf:

Cílem testu je zjistit, zda dojde k persistentnímu ovlivnění generického výkonu počtu transakcí za sekundu mimo +/-5% rozsah a zároveň zda nedojde k dramatickému nárůstu latencí. V čase 1:39 dojde ke spuštění dvou paralelních DSS VM (Data warehouse and decision support systems) s cílem „vykolejit“ výkon podávaný VM s databází. Z horní linie grafu je patrné, že nedošlo k negativnímu ovlivnění výkonu databáze ať už poklesem operací za sekundu či zvýšením latence. V praxi to znamená, že virtuální stroje se nebudou navzájem negativně ovlivňovat a třeba že spuštění procesu zálohy nezpůsobí zhoršení dostupnosti kritické produkční aplikace.

Závěr

Z výsledků testů jsme byli příjemně překvapeni, zvláště když vezmeme v potaz kompaktnost a příznivou cenu clusteru zabaleného v 2U šasi. Potvrdila se nám také důležitost síťové vrstvy, i když i na 10GbE rozhraní poskytuje testovací systém impresivní hodnoty. Přínos nasazení technologie RDMA je pak prakticky pouze na zvážení zákazníka, ale opět jde o zlepšení výkonu o více než 10 procent a cenově je rozdíl prakticky zanedbatelný.

V dnešním článku jsme se věnovali čistě výkonovým parametrům dané konfigurace, ale platí pro ni všechny benefity, které nabízí hyperkonvergovaná infrastruktura Nutanix. Ať už jde o granularitu, škálovatelnost, maximální robustnost a odolnost proti výpadku nebo univerzálnost prakticky pro jakoukoliv zátěž od standardních nekritických systémů až třeba pro SAP HANA.

Pokud by vás zajímaly další detaily nebo obsáhlé protokoly z měření, jsme vám plně k dispozici a neváhejte nás kontaktovat. Plánujeme spustit stejné testy i na hybridní konfiguraci (SSD+HDD) a jejich výsledek i srovnání obou rozdílných clusterů najdete brzy v našem blogu.

Autor: Zdeněk Kopta, červen 2020